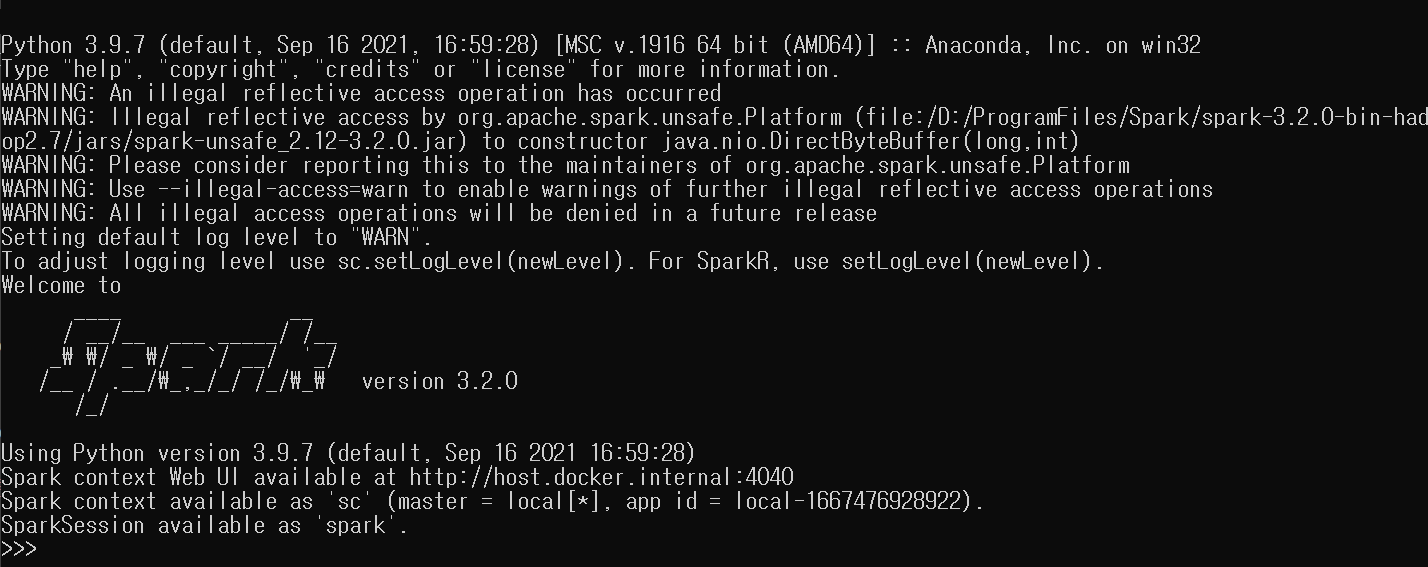

Apache Spark 설치

Window 운영체제

1. Anaconda 설치하기

Anaconda Prompt에서 python 3.8 이상인지 확인

where python 으로 Python이 어디에 설치되어 있는지 확인

pip : python package installerwhere pip으로 pip이 어디에 있는지 확인

pip --version으로 pip 버전 확인

2. JAVA

java --version으로 버전 확인

Extended Support Until이 긴 JAVA 8(LTS)을 다운받는다

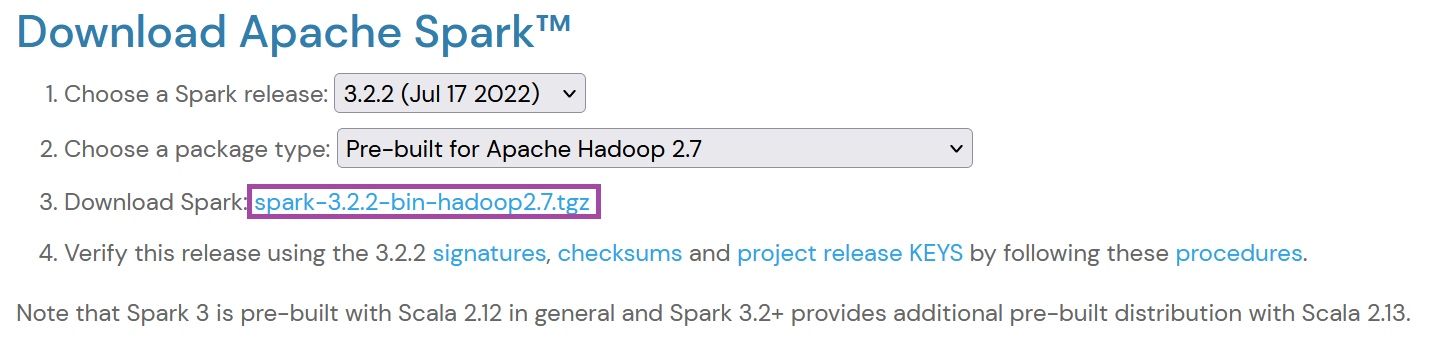

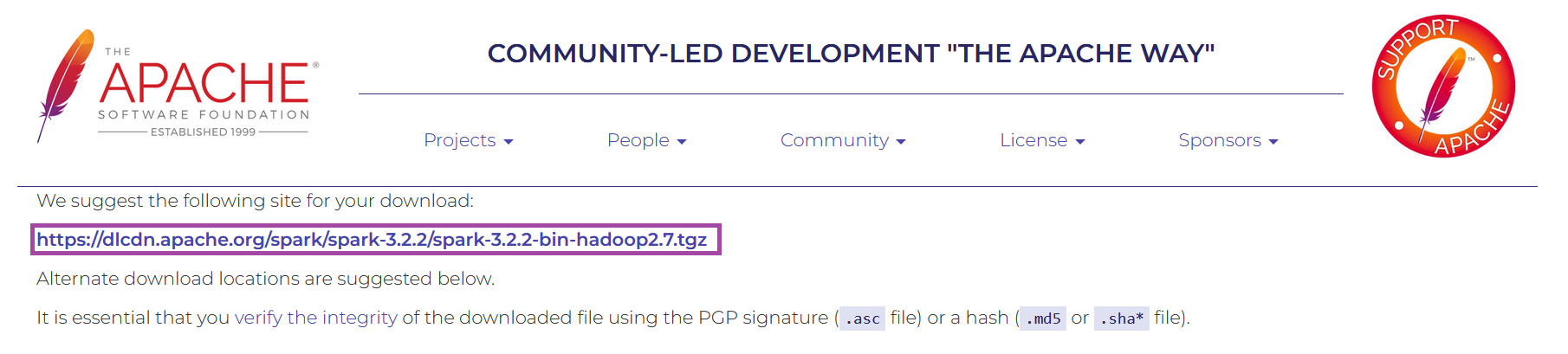

3. Spark

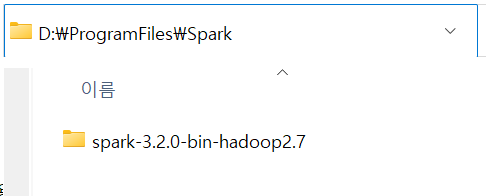

다운받은 파일을 원하는 위치에 이동한다.

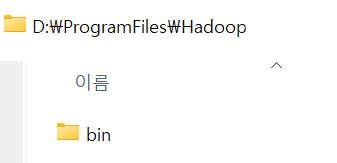

4. Hadoop

hadoop-2.7.7을 사용

다운받은 파일을 원하는 위치에 이동한다.

5. Pyspark

Anaconda Prompt에서 pip install pyspark

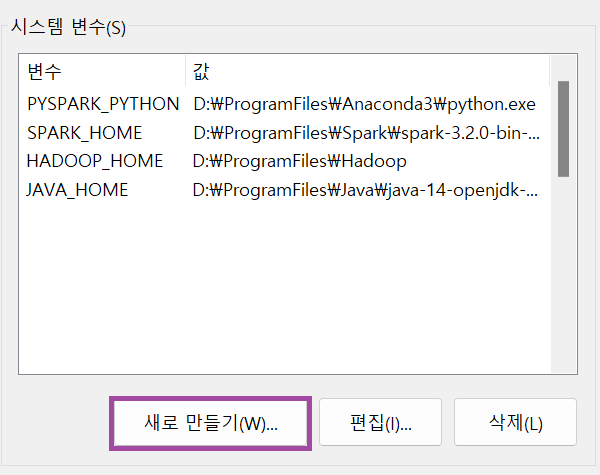

환경변수 설정

주의사항: 파일경로에 빈칸이 존재하면 Error가 발생

JAVA_HOME

D:\ProgramFiles\Java\java-14-openjdk-14.0.2.12\bin

HADOOP_HOME

D:\ProgramFiles\Hadoop

SPARK_HOME

D:\ProgramFiles\Spark\spark-3.2.0-bin-hadoop2.7

PYSPARK_PYTHONwhere python을 해서 D:\ProgramFiles\Anaconda3\python.exe

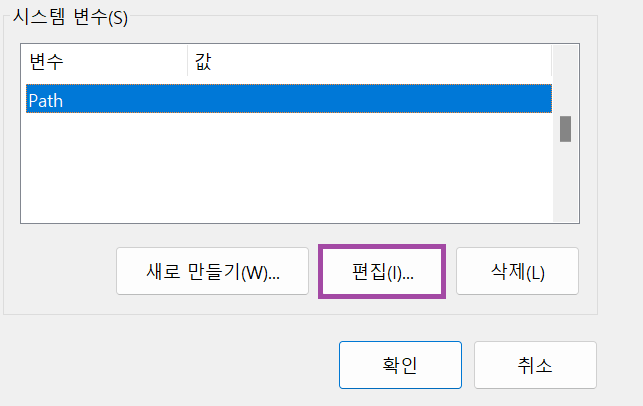

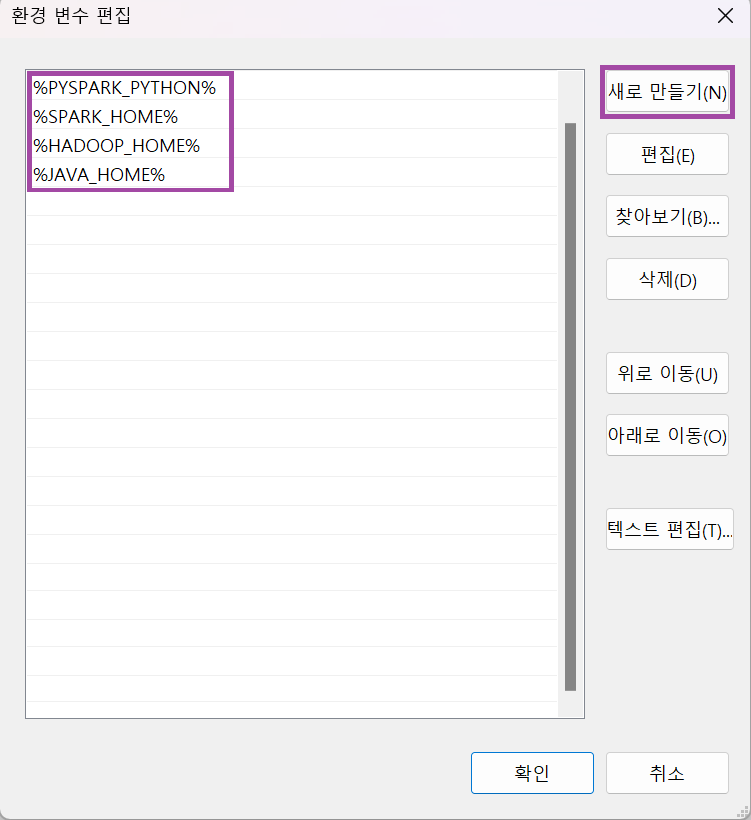

환경변수 > 변수: Path를 선택하여 [편집]버튼을 누르고 아래와 같이 추가

Mac 운영체제

1. Anaconda 설치하기

2. which python 으로 경로 찾기

3. Homebrew 설치

1 | JAVA 버전확인 |